AI旋风了解到,资深机器人专家Eric Jang曾经的预言正在逐步变为现实:“ChatGPT曾在一夜之间出现,我认为,有智慧的机器人技术也将如此。”就在北京时间3月13日深夜,一段人形机器人的视频在社交媒体上迅速传播开来,引发了广泛关注。这段视频由OpenAI投资的机器人公司Figure上传,展示了其人形机器人与人类流畅对话、理解意图、执行自然语言指令以及解释行为的能力。令人震惊的是,这一成果的诞生仅用了短短的13天时间。

在视频中,Figure的人形机器人展现出了令人惊叹的智能水平。它不仅能够与人类进行自然流畅的对话,还能够理解并执行复杂的自然语言指令,如抓取和放置物品等。更为重要的是,机器人在执行这些任务时表现出了极高的自主性和决策能力,能够在没有远程操纵的情况下独立完成任务。

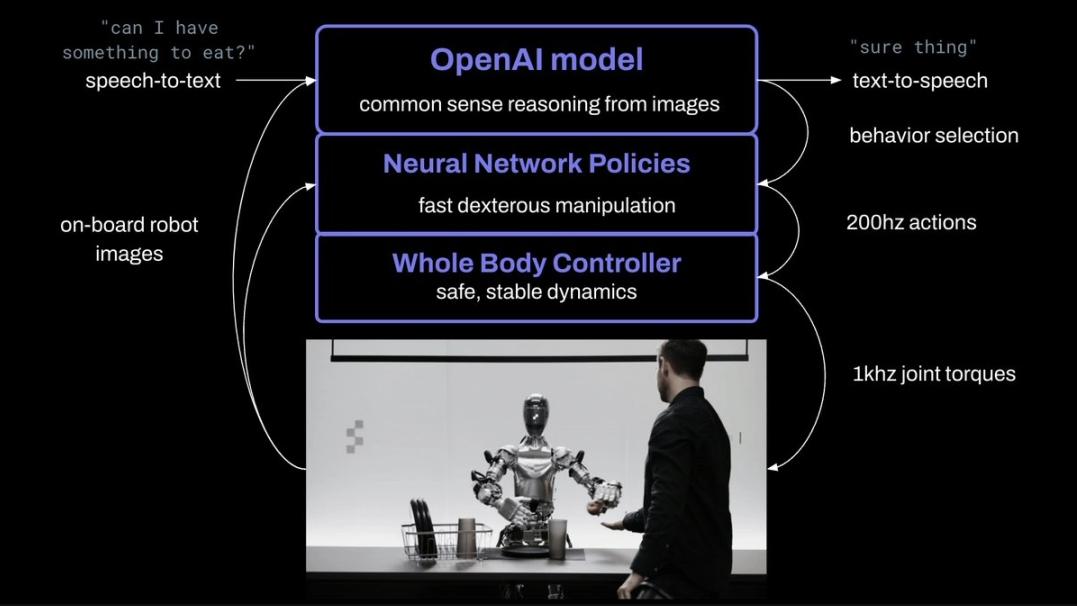

据AI旋风了解,这一成果的背后,是OpenAI为其配置的智能大脑——一个端到端的大语言-视觉模型。该模型具有强大的多模态能力,能够理解图像和文本信息,从而使机器人能够与世界进行交互。与此同时,Figure公司的神经网络则负责提供快速、低水平、灵巧的机器人动作,确保机器人能够高效地完成各种任务。

值得注意的是,从OpenAI宣布与Figure共同合作推进人形机器人领域的前沿研究,到这段视频的发布,仅仅过去了13天时间。这一速度之快,无疑再次证明了人工智能技术的飞速发展。与此同时,这也让我们看到了机器人在未来可能展现出的更加广泛的应用前景。

机器人智能的迅速发展令人叹为观止。与传统的机器人相比,这款人形机器人不仅具备了更高的自主性和决策能力,还在速度上有了显著的提升。据Figure公司的创始人Brett Adcock和AI团队负责人Corey Lynch介绍,机器人的机载摄像头以10hz的频率拍摄图像,而神经网络则以200hz的频率输出24个自由度的动作。这意味着机器人的动作速度已经接近甚至达到了人类的水平。

OpenAI的模型的多模态能力为机器人与世界交互提供了关键支持。从视频中我们可以看到,机器人能够描述周围环境、使用常识推理做出决策、将高级请求转化为适合上下文的行为,并解释自己执行特定操作的原因。此外,模型还具备短期记忆能力,能够正确理解并回应人类提出的关于“它们”和“那里”等指代性问题。

机器人的双手动作能力同样令人印象深刻。通过互联网预训练模型对图像和文本进行常识推理,机器人能够得出高级计划并执行具体的动作。这一过程中,机器人不仅需要根据指令抓取和放置物品,还需要考虑如何以最有效的方式完成任务。这种能力使得机器人在执行复杂任务时表现出了极高的灵活性和适应性。

AI旋风认为,OpenAI和Figure的这一合作成果无疑为机器人领域的发展注入了新的活力。它展示了人工智能技术在机器人智能方面的巨大潜力,也让我们看到了机器人在未来可能实现的更加智能化的应用场景。随着技术的不断进步和应用的不断拓展,相信未来我们将会看到更多具有高度智能和自主性的机器人出现,为人类的生活带来更多便利和惊喜。

渝公网安备50019002504809号

渝公网安备50019002504809号