在人工智能领域,随着模型的日益复杂化,其内部工作机制的理解成为科研人员与工程师们面临的一大挑战。近日,谷歌推出的开源工具Model Explorer,以其独特的功能和潜力,在AI透明度和问责制方面迈出了重要步伐,为解开AI黑箱带来了新的希望。

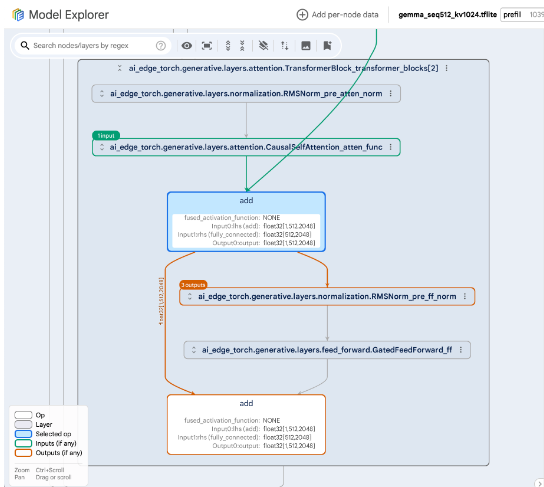

Model Explorer代表了机器学习可视化领域的一大突破。谷歌在官方声明中表示,该工具引入了一种创新的分层方法,使用户能够轻松地浏览最为复杂的神经网络,如目前最先进的语言模型和扩散网络。这一技术的出现,无疑为AI模型的透明度和可解释性提供了新的解决方案。

在现有的可视化工具中,渲染具有数百万节点和边缘的大型模型时往往面临性能缓慢和视觉输出混乱的问题。然而,Model Explorer通过借鉴游戏行业的先进图形渲染技术,成功克服了这些障碍。其独特的设计使得大型模型能够平滑地可视化,同时提供一个直观、易用的界面,让用户能够深入探索模型的内部结构。

Model Explorer的界面设计简洁明了,使用户能够轻松地浏览复杂的AI模型。用户不仅可以查看模型的整体结构,还可以深入到单个层级,检查量化设置和其他关键细节。这一功能对于优化模型性能、减少资源消耗具有重要意义。谷歌表示,Model Explorer已经在其内部得到了广泛应用,显著简化了将大型模型部署到资源受限平台(如移动设备)的过程。

作为谷歌更广泛的“AI on the Edge”计划的一部分,Model Explorer在推动更多人工智能计算到设备上发挥了重要作用。通过打开设备上AI的黑箱,该工具在提升系统透明度和负责性方面展现出了巨大潜力。随着AI技术的广泛应用,确保这些系统能够负责任地运行、维护用户信任成为了一个迫切的需求。Model Explorer的出现,无疑为这一目标的实现提供了有力支持。

AI旋风认为,随着AI技术的飞速发展,理解模型在“引擎盖下”的行为对于建立用户信任、确保负责任的部署至关重要。Model Explorer通过其独特的分层方法和平滑的可视化能力,为深入理解尖端神经网络的内部提供了前所未有的洞察力。这使得研究人员和开发人员能够在开发过程的早期发现潜在的偏见、错误或意外后果,从而确保AI系统的可靠性和安全性。

Model Explorer的发布标志着谷歌在揭开人工智能复杂世界神秘面纱方面迈出了重要一步。该工具不仅为科研人员提供了深入了解AI模型内部工作机制的机会,还为整个AI行业树立了一个负责任、可解释性的新标杆。未来,随着更多类似工具的出现和应用,我们有理由相信AI技术将在保持透明度和问责制的同时,充分发挥其巨大的潜力为社会带来更多福祉。

渝公网安备50019002504809号

渝公网安备50019002504809号