近日,著名研究人员Sepp Hochreiter在深度学习领域取得重要突破,推出了全新的xLSTM(Extended LSTM)神经网络架构。该架构旨在解决传统LSTM网络在处理序列数据时存在的时序依赖问题,并有望与当前热门的Transformer架构展开激烈竞争。

在1997年,Sepp Hochreiter和Jürgen Schmidhuber共同提出了长短期记忆(LSTM)神经网络结构,这一创新性的模型通过引入门控机制,成功解决了循环神经网络(RNN)在处理长序列时面临的长期记忆能力不足的问题。然而,随着时间的推移,LSTM架构在并行化处理数据方面的局限性逐渐凸显,尤其是在处理大规模数据时,其效率受到一定限制。

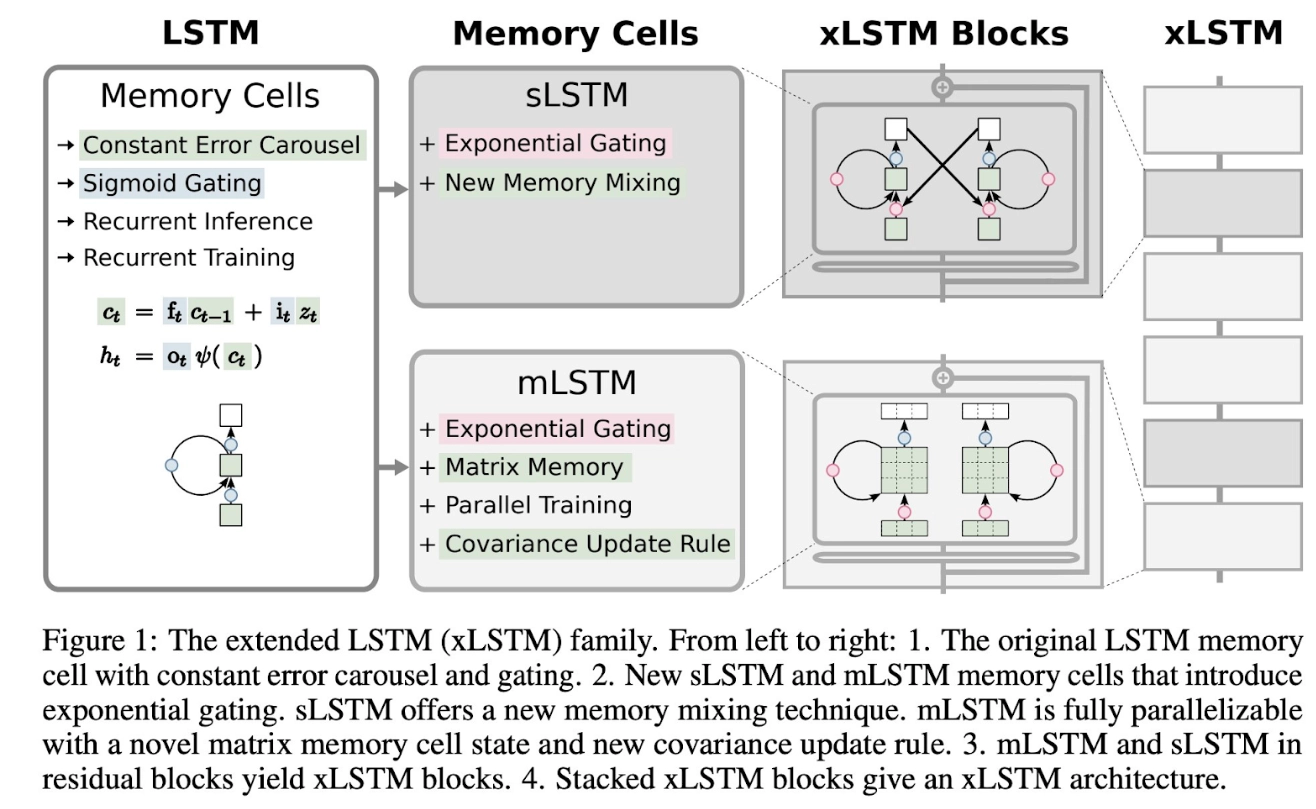

针对这一挑战,Sepp Hochreiter在最新论文中提出了xLSTM架构。AI旋风认为,这一新架构的核心在于引入了指数型门控循环网络,并融合了“sLSTM”和“mLSTM”两项记忆规则。这些改进使得xLSTM能够有效地利用RAM资源,实现类似Transformer架构的并行化处理能力。这意味着xLSTM能够同时处理所有Token,大大提高了数据处理的效率。

为了验证xLSTM架构的有效性,研究团队使用了包含150亿个Token的数据集对基于xLSTM和Transformer架构的两款模型进行了测试。经过评估,xLSTM在多个指标上均表现出色,尤其在“语言能力”方面更是展现出显著优势。这一结果表明,xLSTM在处理大规模数据时具有更高的效率和准确性,有望在未来与Transformer架构展开激烈的竞争。

xLSTM架构的推出对于深度学习领域具有重要意义。一方面,它打破了LSTM在处理数据时的时序依赖限制,实现了更高效的并行化处理能力;另一方面,xLSTM在“语言能力”方面的突出表现也为其在自然语言处理等领域的应用提供了广阔的前景。

尽管xLSTM架构在测试中取得了优异的表现,但要想真正挑战Transformer的霸主地位,还需要进一步的研究和优化。例如,研究人员可以探索更多有效的记忆规则,提高xLSTM在处理复杂任务时的性能。此外,xLSTM架构在实际应用中还需要面对诸多挑战,如如何在不同场景下调整模型参数、如何优化模型的训练过程等。

然而,无论未来发展如何,xLSTM架构的推出都标志着深度学习领域在技术创新方面取得了重要进展。我们期待这一新架构能够在未来的研究中不断成熟和完善,为人工智能领域的发展注入新的活力。同时,我们也期待看到更多优秀的研究人员在这一领域取得更多突破性成果,共同推动人工智能技术的快速发展。

渝公网安备50019002504809号

渝公网安备50019002504809号