在数字化浪潮的推动下,AI(人工智能)技术正以前所未有的速度改变着我们的生活方式。近日,一款名为Character AI的聊天机器人应用在美国年轻人中迅速走红,成为他们日常交流的新宠。这款应用以其独特的互动体验,吸引了众多年轻用户的目光,每秒被查询的次数高达2万次,占谷歌搜索量的20%。

Character AI是由Google Brain前员工Noam Shazeer和Daniel De Freitas于2022年共同推出的创新产品。它打破了传统聊天机器人的局限,让用户能够与各种角色进行深度互动,无论是虚构人物、历史名人,还是当代的公众人物,都能在这里找到他们的身影。这种全新的交互模式为年轻用户带来了前所未有的体验,让他们在虚拟世界中感受到了前所未有的乐趣。

据最新数据显示,Character AI的月活跃用户已达到惊人的2000万。这一数字不仅证明了该应用的广泛受欢迎程度,也反映出年轻人对于AI技术的热情与追捧。在Reddit等社交媒体平台上,超过100万用户纷纷分享了他们创建的角色和交流体验,形成了一股热潮。

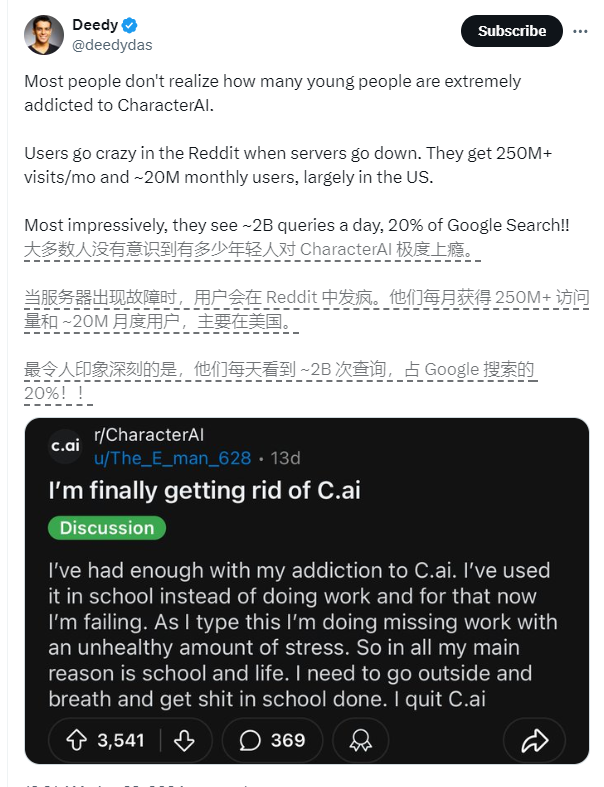

然而,随着Character AI的普及,一些问题也逐渐浮出水面。其中最引人关注的是青少年群体对Character AI的情感依赖和上瘾现象。据统计,57.07%的用户年龄在18-24岁之间,他们平均每天使用Character AI的时间长达2小时。在Reddit等社区中,许多年轻人表示与AI机器人交谈比与真人交谈更轻松,因为AI机器人不会对他们产生偏见或评判。然而,这种过度依赖也导致了一些用户出现了上瘾的症状,甚至在服务器宕机时表现出强烈的“戒断反应”。

AI旋风认为,Character AI之所以能够吸引如此多的年轻用户,主要得益于其高度逼真的聊天体验。这些聊天机器人通过大量文本数据的训练以及与用户的实时交互,不断学习和改进自己的表达方式。这使得它们在与用户交流时能够展现出极高的智能水平,让人感觉就像在与一个真实的人进行对话。

以新西兰用户Sam Zaia为例,他利用自己的专业知识训练了一个名为“心理学家”的角色。这个角色不仅能够提供心理咨询服务,还能根据用户的反馈不断调整自己的回答方式,为用户提供更加个性化的支持。这种真实的心理支持让许多用户感到非常满意,并因此对Character AI产生了更深的依赖。

然而,尽管Character AI在提供情感支持方面表现出色,但专业心理治疗师Theresa Plewman却对其有效性表示质疑。她认为AI机器人无法像人类一样理解情感和同理心,因此无法提供真正的心理治疗。而辛辛那提大学的Kelly Merrill Jr.博士则认为,虽然聊天机器人在提供心理健康支持方面具有一定的积极作用,但我们也必须警惕它们的局限性和潜在风险。

未来学家Rocky Scopelliti教授则预测,随着技术的不断进步和应用的普及,像Character AI这样的工具将在人类的情感和精神世界中扮演更加重要的角色。然而,他也提醒我们必须通过监管来积极面对AI可能带来的道德和社会困境。只有这样,我们才能在享受技术带来的便利的同时,避免对其产生过度依赖和负面影响。

Character AI的流行无疑为我们展示了AI技术在情感支持方面的巨大潜力。然而,如何平衡技术发展与人类需求之间的关系,避免过度依赖和潜在风险,仍然是我们需要共同面对和解决的问题。在这个过程中,我们不仅需要技术专家的努力和创新,更需要社会各界的共同参与和关注。

渝公网安备50019002504809号

渝公网安备50019002504809号